Zusammenfassung

Es gibt Hinweise darauf, dass nordkoreanische IT-Mitarbeiter die Deepfake-Technologie in Echtzeit nutzen, um Unternehmen über Remote-Arbeitsplätze zu infiltrieren, was erhebliche Sicherheits-, Rechts- und Compliancerisiken birgt. Die in diesem Bericht dargelegten Erkennungsstrategien bieten Sicherheits- und HR-Teams praktische Anleitungen, um ihre Einstellungsprozesse gegen diese Bedrohung zu stärken.

In unserer Demonstration brauchte man ohne Vorkenntnisse etwas mehr als eine Stunde, um herauszufinden, wie man mit leicht erhältlichen Werkzeugen und billiger Consumer-Hardware ein Deepfake in Echtzeit erstellt. Auf diese Weise können Angreifer leicht überzeugende synthetische Identitäten schaffen, die es ihnen ermöglichen, unentdeckt zu operieren und möglicherweise Einnahmen für sanktionierte Regime zu erzielen.

Auch wenn wir bei der derzeitigen Deepfake-Technologie noch Einschränkungen feststellen können, so nehmen diese doch rasch ab. Unternehmen müssen einen mehrschichtigen Schutz implementieren, indem sie verbesserte Überprüfungsverfahren, technische Kontrollen und eine kontinuierliche Überwachung während des gesamten Lebenszyklus der Mitarbeiter kombinieren.

Palo Alto Networks Kunden sind vor den in diesem Artikel beschriebenen Bedrohungen dank der Unit 42 Insider Threat Services besser geschützt.

Organisationen können sich an das Unit 42 Incident Response Team wenden, um spezielle Unterstützung bei dieser und anderen Bedrohungen zu erhalten.

Nordkoreaner im Vorstellungsgespräch

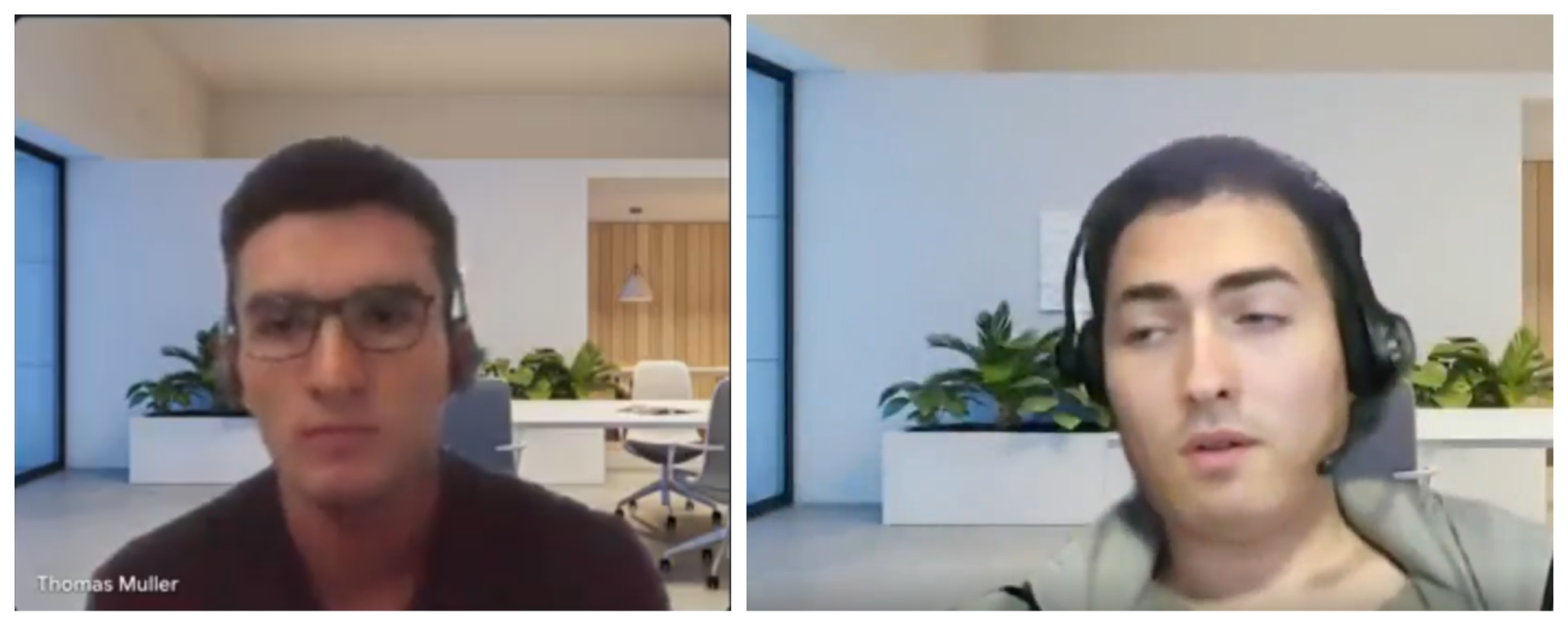

Die Talentakquise- und Cybersicherheits-Communitys haben in letzter Zeit berichtet, dass immer mehr Bewerber bei Vorstellungsgesprächen Echtzeit-Deepfakes einsetzen. Die Ermittler haben Fälle dokumentiert, in denen Befragte synthetische Videofeeds mit identischen virtuellen Hintergründen für verschiedene Kandidatenprofile nutzten, wie in Abbildung 1 dargestellt.

Der Pragmatic Engineer-Newsletter dokumentierte eine Fallstudie über ein polnisches KI-Unternehmen, das auf zwei verschiedene Deepfake-Kandidaten stieß. Die Personaler vermuteten, dass ein und dieselbe Person hinter beiden Personas steckte, vor allem, da der Bewerber während des zweiten technischen Vorstellungsgesprächs deutlich mehr Selbstvertrauen zeigte, nachdem er zuvor das Format und die Fragen kennengelernt hatte.

Die Analyse der Indikatoren im Pragmatic Engineer-Bericht durch Unit 42 deckt sich mit bekannten Taktiken, Techniken und Prozeduren (TTPs), die den Operationen von IT-Mitarbeitern der Demokratischen Volksrepublik Korea (DVRK) zugeschrieben werden. Dies ist eine logische Weiterentwicklung ihres bewährten Schemas der betrügerischen Infiltrierung von Arbeitsplätzen.

Nordkoreanische Bedrohungsakteure haben stets ein großes Interesse an Techniken zur Identitätsmanipulation gezeigt. In unserer Untersuchung im Jahr 2023 berichteten wir über ihre Bemühungen, synthetische Identitäten zu schaffen, die sich auf kompromittierte persönliche Daten stützen, um ihre Entdeckung zu erschweren.

Wir fanden weitere Beweise, als wir den Angriff auf Cutout.pro, einen AI-Dienst für die Bildmanipulation, bei dem zahlreiche E-Mail-Adressen aufgedeckt wurden, die wahrscheinlich mit den IT-Mitarbeitern der DVRK in Verbindung stehen, analysierten. Abbildung 2 zeigt eine derartige Bildmanipulation in Form von Bewerbungsfotos mit vertauschten Gesichtern.

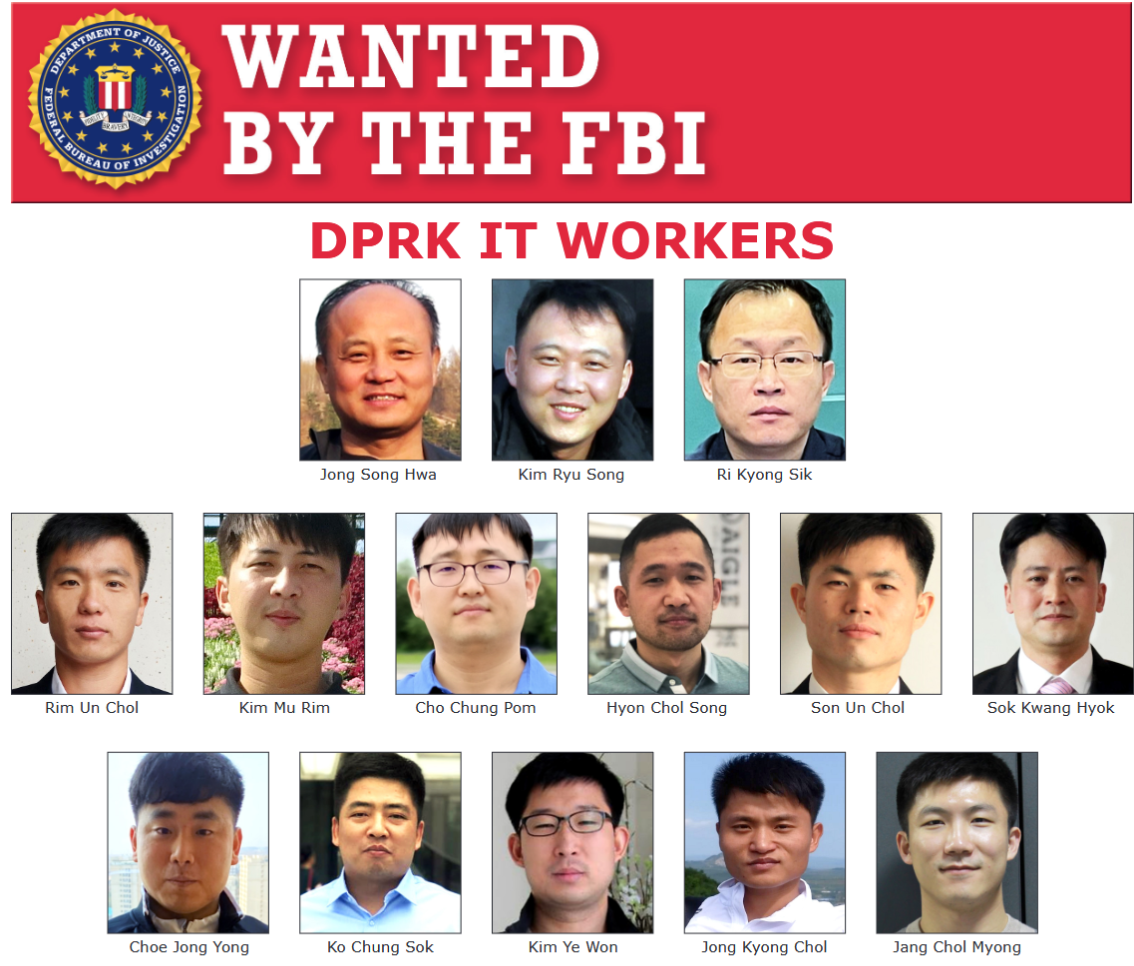

Die IT-Mitarbeiter der DVRK entwickelten ihre Infiltrationsmethoden schrittweise weiter, indem sie die Deepfake-Technologie in Echtzeit einsetzten. Dies bietet zwei wesentliche operative Vorteile. Erstens kann ein und derselbe Mitarbeiter für dieselbe Stelle mehrere Vorstellungsgespräche führen, indem er verschiedene synthetische Personas verwendet. Zweitens können sie verhindern, dass Agenten identifiziert und in Sicherheitsbulletins und Fahndungsmeldungen (siehe Abbildung 3) aufgenommen werden. Zusammengenommen bietet die Technologie den IT-Mitarbeitern der DVRK eine höhere Betriebssicherheit und ein geringeres Erkennungsrisiko.

Von null bis passabel

Ein einzelner Forscher ohne Erfahrung in der Bildmanipulation, mit begrenzten Kenntnissen im Bereich Deepfake und einem fünf Jahre alten Computer erstellte in 70 Minuten eine synthetische Identität für Vorstellungsgespräche. Die Einfachheit der Erstellung zeigt, wie gefährlich zugänglich diese Technologie für Bedrohungsakteure geworden ist.

Nur mit einer KI-Suchmaschine, einer passablen Internetverbindung und einer Ende 2020 gekauften GTX 3070-Grafikeinheit konnte das in Abbildung 4 gezeigte Beispiel erstellt werden.

Abbildung 4. Eine Demonstration eines Deepfakes in Echtzeit auf billiger und weithin verfügbarer Hardware.

Der Forscher verwendete ausschließlich Einzelbilder, die von thispersonnotexist[.]org generiert wurden, das die Verwendung von generierten Gesichtern für persönliche und kommerzielle Zwecke gestattet, sowie kostenlose Tools für Deepfakes. Mit diesen generierte er mehrere Identitäten, wie in Abbildung 5 dargestellt.

Abbildung 5. Eine Demonstration des Identitätswechsels.

Eine einfacher Wechsel der Kleidung und des Hintergrundbildes könnte alles sein, was nötig ist, um einem Personalverantwortlichen als brandneuer Bewerber zu erscheinen. Der zeitaufwändigste Teil des gesamten Prozesses war die Erstellung eines virtuellen Kamerafeeds für die Aufnahme in der Videokonferenzsoftware.

Mit etwas mehr Zeit und einem leistungsfähigeren Grafikprozessor führte eine High-Resolution-Version desselben Prozesses zu überzeugenderen Ergebnissen, wie in Abbildung 6 dargestellt.

Abbildung 6. Ein Deepfake von höherer Qualität, erstellt mit einer ressourcenintensiveren Technik.

Entdeckungsmöglichkeiten

Es gibt mehrere technische Schwachpunkte bei Echtzeit-Deepfake-Systemen, die Entdeckungsmöglichkeiten schaffen:

- Probleme mit der zeitlichen Konsistenz: Schnelle Kopfbewegungen verursachten merkliche Artefakte, da das Tracking-System Schwierigkeiten hatte, die genauen Positionsmarkierungen beizubehalten.

- Umgang mit Okklusion: Wenn die Hand des Bedieners sich vor dem Gesicht befand, konnte das Deepfake-System das teilweise verdeckte Gesicht nicht richtig rekonstruieren.

- Anpassung der Beleuchtung: Plötzliche Änderungen der Lichtverhältnisse führten zu Unstimmigkeiten in der Darstellung, insbesondere an den Rändern des Gesichts.

- Audiovisuelle Synchronisation: Leichte Verzögerungen zwischen Lippenbewegungen und Ton waren bei sorgfältiger Beobachtung feststellbar.

Gegenwärtig gibt es mehrere Möglichkeiten, den Möchtegern-Deepfakern das Leben schwer zu machen. Die effektivste Methode scheint zu sein, die Hand vor das Gesicht zu bewegen, was die Verfolgung der Gesichtsmerkmale unterbricht.

Govind Mittal et al. von der New York University schlagen zusätzliche Strategien vor:

- Schnelle Kopfbewegungen

- Überspitzter Gesichtsausdruck

- Plötzliche Änderungen der Beleuchtung

Diese Techniken nutzen Schwachstellen in Echtzeit-Deepfake-Systemen aus und verursachen sichtbare Artefakte, die Menschen helfen, Fälschungen mit hoher Genauigkeit zu erkennen.

In den Abbildungen 7a–c zeigen wir drei weitere Optionen, die zum Repertoire eines Personalers gehören sollten.

Figure 7a. The “Abbildung 7a. Das „Ohr-an-Schulter”

Abbildung 7b. Die „Nasenshow“.

Abbildung 7c. Der „Himmel-oder-Boden“.

Abhilfestrategien

Die Kampagne der IT-Mitarbeiter der DVRK erfordert eine enge Zusammenarbeit zwischen den Teams für Human Resources (HR) und Informationssicherheit. Wenn beide zusammenarbeiten, bietet dies einem Unternehmen mehr Erkennungsmöglichkeiten über den gesamten Einstellungs- und Beschäftigungslebenszyklus hinweg.

Haftungsausschluss: Die folgenden Abhilfestrategien sollen dem Leser Einblicke und Anregungen geben, die berücksichtigen werden können. Diese werden nur zu Informationszwecken zur Verfügung gestellt und sollten nicht als Rechtsberatung angesehen werden. Bevor eine dieser Praktiken angewendet wird, sollte eigener Rechtsbeistand hinzugezogen werden, um die Übereinstimmung mit den geltenden Gesetzen zu bestätigen.

Für HR-Teams:

- Bitten Sie die Bewerber, ihre Kameras bei Vorstellungsgesprächen, auch bei Erstgesprächen, einzuschalten.

- Zeichnen Sie diese Sitzungen (mit entsprechender Zustimmung) für mögliche forensische Analysen auf.

- Implementieren Sie einen umfassenden Arbeitsablauf zur Identitätsüberprüfung, der Folgendes umfasst:

- Überprüfung der Dokumentenechtheit mithilfe automatisierter forensischer Tools, die auf Sicherheitsmerkmale, Manipulationsindikatoren und die Konsistenz der Informationen in den eingereichten Dokumenten prüfen

- ID-Überprüfung mit integrierter Aktivitätserkennung, die von den Kandidaten verlangt, dass sie ihren physischen Ausweis vorlegen, während sie bestimmte Aktionen in Echtzeit ausführen

- Abgleich zwischen Ausweisdokumenten und der befragten Person, um sicherzustellen, dass die befragte Person mit ihrer angeblichen Identität übereinstimmt

- Schulung von Personalvermittlern und Teams für technische Vorstellungsgespräche in der Erkennung verdächtiger Muster in Video-Vorstellungsgesprächen, wie z. B. unnatürliche Augenbewegungen, uneinheitliche Beleuchtung und audiovisuelle Synchronisationsprobleme

- Die Personaler sollten sich daran gewöhnen, die Bewerber aufzufordern, Bewegungen auszuführen, die für die Deepfake-Software schwierig sind (z. B. Drehungen des Profils, Handgesten in der Nähe des Gesichts oder schnelle Kopfbewegungen)

Für Sicherheitsteams:

- Sicherung der Einstellungspipeline, indem die IP-Adressen von Bewerbern aufgezeichnet werden und überprüft wird, dass sie nicht aus einer anonymisierten Infrastruktur oder verdächtigen geografischen Regionen stammen

- Anreicherung der angegebenen Telefonnummern, um zu prüfen, ob es sich um Voice-over-Internet-Protocol(VoIP)-Anbieter handelt, insbesondere solche, die häufig mit Identitätsverschleierung in Verbindung gebracht werden

- Aufrechterhaltung von Vereinbarungen über den Informationsaustausch mit Partnerunternehmen und Teilnahme an einschlägigen Information Sharing and Analysis Centers (ISACs), um über die neuesten Techniken im Zusammenhang mit synthetischen Identitäten auf dem Laufenden zu bleiben

- Identifizierung und Blockierung von Softwareanwendungen, die die Installation virtueller Webcams auf vom Unternehmen verwalteten Geräten erlauben, wenn es keine legitime geschäftliche Rechtfertigung für ihre Verwendung gibt

Zusätzliche Indikatoren:

- Überwachung auf abnormale Netzwerkzugriffsmuster nach der Einstellung, insbesondere Verbindungen zu Anonymisierungsdiensten oder nicht genehmigte Datenübertragungen

- Einsatz von Multi-Faktor-Authentifizierungsmethoden, die den physischen Besitz von Geräten erfordern, was die Identitätsnachahmung erschwert

Organisatorische Überlegungen:

- Entwicklung klarer Protokolle für den Umgang mit Verdachtsfällen synthetischer Identität, einschließlich Eskalationsverfahren und Methoden zur Beweissicherung

- Erstellung eines Programms zur Sensibilisierung für Sicherheitsfragen, das alle Mitarbeiter, die an der Einstellung von Mitarbeitern beteiligt sind, über Warnhinweise zu synthetischen Identitäten aufklärt

- Einrichtung technischer Kontrollen, die den Zugang für neue Mitarbeiter beschränken, bis zusätzliche Verifizierungsmeilensteine erreicht sind

- Dokumentation von fehlgeschlagenen Verifizierungen und Weitergabe entsprechender technischer Indikatoren an Industriepartner und zuständige Regierungsstellen

Durch die Implementierung dieser mehrstufigen Erkennungs- und Abhilfestrategien können Unternehmen das Risiko der Infiltration mit synthetischen Identitäten erheblich reduzieren und gleichzeitig einen effizienten Einstellungsprozess für legitime Bewerber aufrechterhalten.

Fazit

Die Bedrohung durch synthetische Identitäten, wie sie von nordkoreanischen IT-Mitarbeitern ausgeht, stellt für Unternehmen weltweit eine immer größere Herausforderung dar. Unsere Forschung zeigt, dass synthetische Identitäten zunehmend einfach zu erstellen sind, wobei die technischen Hürden immer niedriger werden, da KI-generierte Gesichter, Werkzeuge zur Dokumentenfälschung und Technologien zur Manipulation von Stimmen und Videos in Echtzeit immer ausgefeilter und leichter verfügbar werden.

Da sich die Technologien für synthetische Identitäten ständig weiterentwickeln, müssen Unternehmen mehrschichtige Verteidigungsstrategien einführen, die Folgendes umfassen:

- Verbesserte Überprüfungsverfahren

- KI-gestützte Gegenmaßnahmen zur Erkennung von Deepfakes

- Kontinuierliche Überprüfung während der gesamten Beschäftigung

Dieser Ansatz verbessert die Fähigkeit eines Unternehmens erheblich, nicht nur nordkoreanische IT-Mitarbeiter, sondern auch eine Vielzahl ähnlicher Bedrohungen zu erkennen und zu bekämpfen.

Keine einzelne Erkennungsmethode kann den Schutz vor synthetischen Identitätsbedrohungen garantieren, aber eine mehrschichtige Verteidigungsstrategie verbessert die Fähigkeit Ihres Unternehmens, diese Risiken zu erkennen und zu mindern, erheblich. Durch die Kombination bewährter HR-Verfahren mit Sicherheitskontrollen können Sie einen effizienten Einstellungsprozess aufrechterhalten und sich gleichzeitig vor den ausgeklügelten Taktiken nordkoreanischer IT-Mitarbeiter und ähnlicher Bedrohungsakteure schützen.

Kunden von Palo Alto Networks können sich mit den Unit 42 Insider Threat Services besser gegen die oben genannten Bedrohungen schützen und die Erkennung und Beseitigung ganzheitlich verbessern.

Wenn Sie glauben, dass Sie kompromittiert wurden, oder ein dringendes Anliegen haben, wenden Sie sich an das Unit 42 Incident Response Team oder rufen Sie an:

- Nordamerika: Gebührenfrei: +1 (866) 486-4842 (866.4.UNIT42)

- UK: +44.20.3743.3660

- Europa und Naher Osten: +31.20.299.3130

- Asien: +65.6983.8730

- Japan: +81.50.1790.0200

- Australien: +61.2.4062.7950

- Indien: 00080005045107

Palo Alto Networks hat diese Erkenntnisse mit den anderen Mitgliedern der Cyber Threat Alliance (CTA) geteilt. CTA-Mitglieder nutzen diese Informationen, um ihren Kunden schnell Schutzmaßnahmen bereitzustellen und böswillige Cyber-Akteure systematisch zu stören. Erfahren Sie mehr über die Cyber Threat Alliance.

Zusätzliche Ressourcen

- Nordkoreanischer Fake-IT-Mitarbeiter mit Phishingangriff auf BeaverTail- Videokonferenz-App in Verbindung gebracht – Unit 42, Palo Alto Networks

- Globale Unternehmen zahlen unwissentlich an Nordkoreaner: So fängt man sie ein – Unit 42, Palo Alto Networks

- Hacking von Arbeitgebern und Arbeitssuche: Zwei berufsbezogene Kampagnen tragen die Handschrift von DVRK-Bedrohungsakteuren – Unit 42, Palo Alto Networks

- „Ansteckendes“ Vorstellungsgespräch: DVRK-Bedrohungsakteure bewegen Arbeitssuchende in der Tech-Branche zur Installation neuer Varianten von BeaverTail- und InvisibleFerret-Malware – Unit 42, Palo Alto Networks

- Erwischt: Deepfake-Erkennung von Videos in Echtzeit mittels Challenge-Response – Govind Mittal, Chinmay Hegde, Nasir Memon

- KI-Fälscher bei der Rekrutierung von Tech-Entwicklern entlarvt: Postmortem – Gergely Orosz, The Pragmatic Engineer

- So läuft ein Deepfake-Vorstellungsgespräch ab – Billy Hurley, IT Brew

- Die aufkommende Dynamik von Deepfake-Betrugskampagnen im Internet – Unit 42

Erhalten Sie Updates von Unit 42

Erhalten Sie Updates von Unit 42